新闻动态

News Center

【摘 要】虽然人工智能技术逐步应用于政府服务的各个领域,但少有研究关注民众对公共服务中人工智能主体的初步认知和服务失败后的认知变化。本研究基于预期违背理论和心智感知理论提出,相较于对人类,民众对公共服务中的人工智能有更高的能力期待和更低的感知能动性。因此,当服务失败时,民众对公共服务中的人工智能有更强烈的预期违背和较低的责任归因。我们设计了两个实验来验证上述研究假设。这一研究结论能够为基于人工智能的公共服务模式变革和伦理风险研究提供理论指导和政策建议。

【关键词】人工智能 公共服务 公共决策 服务失败 心智感知 预期违背

一、问题的提出

随着人工智能技术(Artificial Intelligence,AI)在商业领域的成功,公共部门开始在公共服务领域,特别是与公共价值和“国家—公民关系”密切相关的公共决策领域部署AI 系统(例如,预防犯罪、移民审批、税务金融与司法判决等),以期提高服务效率和质量(Wirtz et al.,2019)。借助强大的学习与信息处理能力,AI 可以对不同环境做出快速反应,帮助公共部门标识出最具有价值的政策目标,运用逻辑分析给出公共服务解决方案设计并对备选方案进行模拟和评估,从而为决策者提供决策评价甚至改善建议,实现辅助或是代替决策者做出理性抉择(张成福、王祥州,2023)。因此,一些公共部门为了提升公共服务的决策能力,已经开始将一些业务的整个决策流程完全交由AI,从而实现“无人干预的”全自动决策,如根据征信数据决定是否发放贷款、匹配求职人员技能与岗位等(Berryhill et al.,2019;Janssen et al.,2020;雷刚,2023)。针对这一情况,已经有不少学者指出,在公共服务决策流程中使用AI,意味着政府实质上委托AI 代行治理决策、在二者间构成了一种“委托—代理”关系,从而使AI 在事实上成为了公共服务中的重要决策主体(Coeckelbergh,2019;Busuioc,2021;杨建武,2022;雷刚,2023)。然而,实践证明,与人类决策者一样,AI 系统及其做出的决策建议并非完美无缺:在美国、澳大利亚等西方国家,被直接运用于司法或行政决策的人工智能工具在实践中已经多次发生错误,并对公众利益产生了实质性的损害(Mayson,2019;Akter et al.,2021)。在传统的完全由人类负责的公共服务过程中,那些有偏见的、不受欢迎的结果的责任通常能够被归因为具体的实体、环节或个人。相比之下,人们尚未在“谁该为由AI 导致的公共服务失败负责”这一伦理问题上达成共识(Boyd & Wilson,2017)。由于在技术上缺乏透明性,AI 系统及其产生结果的过程很大程度上处于“黑箱”之中;同时,各国政府普遍缺乏掌握相关专业知识的雇员和部门,它们通常也不具备自主开发AI 系统或评估供应商产品的能力;这使得不仅是普通人,甚至是它的设计者也很难预测、控制或解释AI的决策逻辑、基础和行为,也就无法按照传统的行政伦理对其进行问责(Wirtz et al.,2019;Schiff et al.,2021;杨建武,2022)。相应的,公共部门也有可能借助AI决策的“无人化”的特点,对产生不良后果的公共决策和行政行为进行避责(赵洲洋,2022;雷刚,2023)。由此,不少学者指出,在公共服务中使用AI 决策将可能导致“责任风险”(Accountability Risks)或“责任赤字”(Accountability Deficits),从而使AI参与的公共服务面临所谓的“责任困境”(Issues of Accountability)(Coeckelbergh,2019;Busuioc,2021;黄素珍,2020;李良成、李雨青,2021;杨建武,2022)。而对于作为公共服务和行政行为接受方的民众而言,他们对于政府、公共政策的态度,特别是认同和信任的产生,主要源于他们对相关过程和结果的质量以及是否满足公共价值的感知和判断(郑建君,2013;孟天广、杨明,2012)。因此,一个现实问题也将随之产生:民众将如何看待参与公共服务决策流程的AI 系统?当来自AI 的决策和服务结果无法满足民众的期望,甚至对他们造成损害时,民众的态度将发生怎样的变化?然而,现有研究尽管已经注意到AI 的嵌入将使公共服务的责任关系复杂化并可能导致“责任困境”,但缺乏从公共决策和公共服务的接受方的视角展开探讨。相应的实证研究,特别是围绕“民众对AI 参与的公共服务决策过程的理解和态度”这一关键问题的实证研究尚处于空白。针对上述问题,本研究将从预期违背理论与心智感知理论切入,构建一个基于民众对于公共决策主体身份感知的态度模型,并在此基础上提出理解智能化公共决策中的责任困境的分析路径,以期为基于AI 的公共服务模式变革和伦理风险研究提供参考。

二、理论基础与研究假设

(一)预期违背理论

预期违背理论(Expectancy Violations Theory)发端于社会学与传播学研究,旨在探讨一种人与人互动适应的模式,对预测和解释社会交往现象起着重要的作用(Burgoon,1993)。该理论的核心概念是“预期”,“预期”指的是普遍意义上人们所期望的行为。这种预期既包括规范性预期,即基于社会规范所认可的行为标准所形成的预期,也包括预测性期望,即基于人们依据被观测者过去行为模式、对其未来行为表现的预期。相应的,预期违背的程度指的是被观测者的实际表现与观测者对其期望之间差异的大小(Kim,2014)。

预期违背理论认为,个体通常会依据他人的行为表现,形成对其在特定情况下应如何表现的预期。而一旦他人违背了被赋予的期望,就会激发起人们的预期违背感知,并产生进一步的认知反应,人们会试图通过解释对方的行为来应对这种消极唤醒,进而做出相应的反应(Burgoon,1993)。个体对他人行为的反应则是由预期违背的方向和程度决定的,预期违背的方向可以是积极的,也可以是消极的。一般而言,实际表现对期望的违背程度越高,人们的反应越强烈,特别是在遇到消极违背时,会激发出人们高强度的消极情绪(Kim,2014)。

尽管预期违背理论在早期仅被用于预测和解释“人”与“人”之间的社会交往活动,但是在随后的应用中,这一理论被延展到更广义的“人”与“主体”间的互动,尤其是“人”与“拟人化”或“类人化”主体(如企业、机器人等)间的互动(Burgoon et al.,2016;张丹妮、刘春林,2022)。尤其是随着技术的进步,研究发现,当交互性的机器人传递出更多的社会性线索时,人们将倾向以人际交互模式与其互动(Cassell & Tartaro,2007)。因此,随着人们越来越认为AI 兼具有“人类”与“机器”的双重特质,已经有越来越多的研究开始依据预期违背理论,探讨人与AI 之间的互动关系,特别是对于AI 行为或决策产生意料之外的结果时的认知(Hong et al.,2021a,2021b;Grimes et al.,2021;Lew & Walther,2022)。本 研 究也延续了这一理论视角,用于进一步探讨民众对AI 参与的公共服务决策失败的反应。

(二)心智感知理论

Gray 等学者的研究发现,人类的心智(Mind)可以归为两个独立的维度——感受性(Experience) 和 能 动 性(Agency)(Gray et al.,2007)。感受性是人类对情绪、感受和基本神经反映(例如,饥渴、伤痛等)体验的能力;能动性是人类完成自我控制、判断、沟通、思考、记忆等行为的能力。在此基础之上,Waytz与Gray 等学者提出了心智感知理论(Theory of Mind Perception)。该理论认为,主体通过对客体所具有的感受性和能动性的感知,从而形成对各类实体(例如,人、动物、AI 等)所具备的心智(Mind)的主观感知,而这一感知又会进一步影响个体对它们的评估和反应(Waytz et al.,2010;Schein & Gray,2018)。

由于该理论将“非人化”与“拟人化”程度解释为,非人类实体(如AI、计算机、动物)在上述两个维度距离“人类”的程度,即“去心智化”程度,因此“去心智化”(Dementalization)(即,对实体所拥有的心智程度的否定)既可以是对其中某一个维度的,也可能是对两个维度的同时否定(杨文琪等,2015)。基于此,既有研究主要从感受性和能动性两方面中的一个,或者全部来探讨个体对AI 和人类的主观感知差异(Bigman & Gray,2018;蒋路远等,2022)。

(三)完美能力期待及其逆反:人类对AI 的启发式认知

随着技术的进步,AI 正在逐渐成为人类劳动的重要辅助和替代。无论是在简单的重复性任务(如搬运、标记),还是在复杂的决策、推理任务(如投资决策、风险识别),AI 技术正在不断普及(Huang & Rust,2018)。与此同时,人们逐渐意识到基于AI 的决策过程不会受到“有限的精力、非理性决策和认知偏差”等一些人类固有缺点的约束(李思贤等,2022)。人们相信相较于一般人类决策者,AI 往往能给出更好的决策建议(李游、常亚平、梁哲浩,2022)。例如,有实证研究发现,在音乐推荐与预测方面,人们更有可能接受来自AI 而不是人类的建议(Logg et al.,2019)。同时,人们认为由AI 撰写的新闻报道产生更少的党派偏见而更加可信(Cloudy et al.,2021)。因此,有学者指出我们正生活在一个越来越依赖AI 决策的时代(Aroyo et al.,2021)。

有研究指出,人们对AI 决策能力的高期待水平来自对AI 的启发式判断。具体而言,社会认知理论(Social Cognition Theory)指出人们倾向于依赖由背景线索触发的心理启发式(Mental Heuristics)来做认知判断,而不是进行全面深入的评估(Fiske & Taylor,2013)。从普通用户的视角来看,AI 具有极高的“黑箱”属性,同时,他们关于AI 的信息主要来自媒体对AI的塑造(Banks,2020)。虽然AI 具有人类和机器的双重特征,但人们往往更加关注AI“准确、一致、稳定”等机器性特征(Jones-Jang& Park,2022)。因此,学者们发现,人们通常相信AI 是以“预先编程的、客观的、稳定且一致机器式的方式运作”(Sundar & Kim,2019)。一旦人们确定决策和建议来自AI,他们就往往会根据脑海中涌现的机器特征来进行判断(Sundar,2020)。这一现象也被称为“自动化偏差”(Automation Bias):人们高估了AI 的准确性和一致性,并形成了一种“完美AI”(Perfect Automation Schema)的认知模式(Lee,2018)。相较于来自其他人类决策者的建议和决定,人们更加倾向于认为来自AI 的决策建议是“公正的、客观的、不带有歧视成分的且更加接近于完美的”(Dietvorst et al.,2015;Sundar,2020),因而更愿意在复杂决策和推理任务中遵从AI 的决策建议。相比之下,人类决策者则常被认为是不完美和时常犯错的(Renier et al.,2021)。根据以上论述,我们推测,当民众认为公共服务的决策主体由人类变为AI 时,将会提升民众对于决策主体工作能力的期待,由此我们提出以下假设:

H1:在公共服务决策情境中,相对于传统人类决策者,人们对于AI 有着更高的能力期待。

然而,人们对于AI 的高能力期待也会带来消极的后果。一些研究指出,人们在与AI 互动后发现AI 违背了“完美AI”模式就会产生“算法厌恶”(Algorithmic Aversion)(李游、常亚平、梁哲浩,2022)。预期违背理论(Expectancy Violation Theory)认为,人们通常会对他人在特定情境下的行为表现给予期望(Burgoon,1993),这种期望包括了依据他人过去的行为特征对其未来行为进行预判的预测型期望(Predictive Expectancy)。如前所述,人们通常对于自动化的机器、算法有着先入为主的完美或近乎完美的预期。因此,当AI 的决策出错时,会被人们认为违背了一致性预期;而对人类而言,人们通常认为人类是会从错误中学习成长的,因此当他们犯下同样的错误时并不会违反对于人类的预期(Daschner & Obermaier,2022;Jones-Jang & Park,2022)。由此可见,人们在对AI 和人类决策者的感知中存在一种显著差异:相比于人类决策者,人们对于AI 的性能有着过高的期望,由此导致人们会对AI 所提供的不完美的结果产生更显著的失望感(Cloudy et al.,2021;Daschner & Obermaier,2022)。根据以上论述,我们推测,相比较于人类,来自AI 的错误将会激发起人们更高水平的预期违背感知,由此我们提出以下假设:

H2:在公共服务情境中,相对于人类决策者,当AI 在决策中犯错时,人们会产生更强的预期违背感。

(四)低能动感知与低责任分配:人类对AI的心智判断

心智感知(Mind Perception)理论指出,心智是客观实体拥有思维或智力的程度,表现为分析、处理问题,以及理解、感受世界的能力。这一理论将“心智”归因为两个维度:感受性(Experience)和能动性(Agency),并以此对非人类实体进行感知和评价(Gray et al.,2012)。其中,感受性(Experience)主要体现为体验和共情的能力,是对本能、情绪(如生气、恐惧、痛苦、压力、愤怒、快乐等)的表达和理解能力。研究指出,人们通常不相信AI 具有感受性的能力(Waytz & Norton,2014)。

能动性被认为是思考、推理、计划、归因及执行完成意图的能力,被认为是人类思维与实践结合,主动地、自觉地、有目的地、有计划地反作用于外部世界的特性(Gray et al.,2007)。因此,心智感知理论认为,能动性是使主体能够独立,或至少部分独立地完成某一目标导向的行动的能力(Waytz et al.,2010)(例如,某个主体具备自主地从A 点移动到B 点的能力)。并且,如果这种以目标为导向的行动产生了后果,主体也可能因此而受到赞扬或指责,并对结果产生“责任”(Responsibility)(例如,前文中的主体被命令留在A 点,但是实际上他走到了B 点)。因此,在大多数情况下,人们对主体能动性的感知,与他们对主体责任,特别是道德责任(Moral Responsibility)的归因直接相关(Gray et al.,2012)。换言之,当某个实体被认为具有能动性时,它们也会被视为是自主的——能够做出决定,能够有意识和意志地采取行动——但当事情走入歧途时,它们也被视为负有责任(Schein & Gray,2018)。

研究指出,人们通常认为AI 系统只具有“无需外部干预地完成行动”的最低程度的自主性,而成熟的人类行动者则除了拥有上述能力之外,还包括塑造意愿和意向并进行反思等驱动“有意识地行动的”自主性能力(黄素珍,2020;于雪,2022)。例如,人们倾向于认为,成年人具有非常高的能动性和感受性水平,但机器人和AI 则只具有很低的感受性水平和中等水平的能动性能力(Bigman & Gray,2018)。所以,人们通常将人类行动者认定为“充分的道德行动者”(Full Moral Agent),需要为自身行为承担完全的“主体责任”(Agent Responsibility);而会将AI 视作“不充分的行动者”或“一般行动者”(Agent in General),并且只能为自身的行为承担相应的、但有限的并承担相应的因果性责任(Causal Accountability)(Arico,2012;黄素珍,2020)。

根据以上论述,我们推测,当民众认为公共服务的决策主体由人类变为AI 时,将会降低民众对于决策主体的能动性的感知;同时,当发生服务失败时,人们也会更倾向于相信AI 无法对此承担完全的责任。由此,我们提出以下假设:

H3:在公共服务决策情境中,相对于人类决策者,人们对于AI 的能动性的感知水平更低。

H4:在公共服务决策情境中,相对于人类决策者,当AI 在决策中犯错时,人们更倾向于认为AI 无法承担责任。

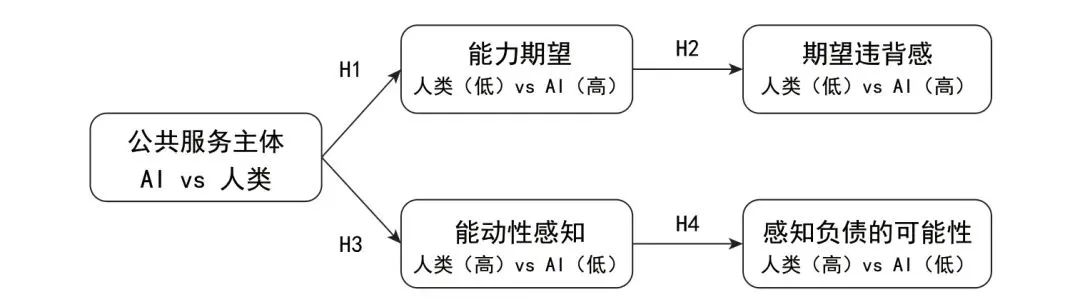

综上所述,本研究将上述4 个假设归纳成理论研究模型,见图1。

图1 理论模型

本研究通过2 项情景锚定的实验室实验研究,检验在公共服务情境下,民众对决策主体的感知会使他们对于公共服务的认知、特别是对于公共服务失败的认知产生怎样的影响①由于在探识别因果效应和挖掘因果机制方面具有独特优势,实验方法已成为当前的社会科学研究方法的前沿。通过随机化配置干预、标准化操作、可控条件和时序性,实验方法研究具有很高共通性和可复制性。按照实验设计类型,本研究采用了情景锚定的实验室实验设计。这一方法起源于心理学研究,具有数据产生过程全程受控、最大化因果推论的内部效度的特点。(参见Druckman J N, Green D P, Kuklinski J H, et al. The growth and development of experimental research in political science[J]. American Political Science Review, 2006, 100(4): 627-635.;Gerring J. Causal mechanisms: Yes,but…[J]. Comparative political studies, 2010, 43(11): 1499-1526.)。实验1将检验在公共服务中的决策主体为AI时,民众对于决策能力的期望以及感知决策主体的能动性的影响。实验2 检验在公共服务失败的场景下,民众对于AI 决策主体的能力认知的调整和责任分配。

三、研究设计与实验分析

(一)实验1

实验设计及实施步骤

实验1 的主要目的是检验公共服务中的决策主体对于民众认知的影响。实验问卷调研的起止时间为2022 年11 月24 日至25 日,采用两组组间实验设计。委托深圳见数公司在网络平台上发布问卷,从该公司400 万会员的样本库中随机抽取106 名被试。在剔除未通过注意力检测和答题时间过短(低于180 秒)和过长(长于600 秒)的被试后,得到100 份有效问卷,有效率为94.3%。被试平均年龄为31.6 岁,其中男性36 人,占36%。

通过借鉴现有的“人—AI”互动研究,我们利用服务情景想象的方法,操纵被试所感知的在公共服务情景下的决策主体② 情景想象是实验室实验中的一种常见的操纵设计。现有研究证实,通过要求被试阅读不同的材料、或根据不同的指引进行想象,可以有效操纵他们的自我身份认知或对其他主体的身份认知。(参见:Nancy R. Buchan et al. Global Social Identity and Global Cooperation[J]. Psychological Science, 2011, 22(6): 821-828.;Arikan E, Altinigne N, Kuzgun E, et al. May robots be held responsible for service failure and recovery? The role of robot service provider agents' human-likeness[J]. Journal of Retailing and Consumer Services, 2023, 70: 103175.)(Yam et al.,2021;Arikan et al.,2023)。本研究根据真实的“北京市行政服务中心”官方网站上对自身的介绍,构建起基本的实验情景和两组实验刺激材料。在实验开始前,我们将全体被试以随机方式平均分配到两个分组中,2 组被试将根据分组情况阅读下文中2 种刺激材料中的一种。随后,实验程序如下:被分入“人工服务组”的被试,将看到一段关于当地行政服务中心的简介,并在简介的最后一段告诉被试,“该中心目前共有100 个行政事业及公共服务单位、1000 多名工作人员进驻,负责为广大市民办理与审批各个公共服务事项”,并配有一张以办事工作人员元素为主体的宣传海报。而被分入“AI 服务组”的被试,则会看到一段与上一组几乎完全一致的简介,只是最后一段关于入驻单位和工作人员规模的表述被替换为“该中心目前使用的‘城市大脑’AI 系统,负责为广大市民‘无人化’地办理与审批各个公共服务事项”。

被试在阅读完实验材料后,在通过操纵检测后,填写关于能力预期水平、感知能动性的量表。随后,被试被要求填写一份关于性别、年龄、职业、收入等人口统计信息和控制变量的简短问卷。

2.变量测量

实验1 主要关注两个因变量:被试对于公共服务中的决策主体的能力预期水平、感知能动性。

(1)因变量1:能力预期水平①能力预期是对主体能否完成某一特定任务的主观判断,通常以“在多大程度上认为XX 是否有能力完成XX”的方式进行测量。(参见Logg Jennifer M., Minson Julia A., Moore Don A. Algorithm appreciation: People prefer algorithmic to human judgment[J]. Organizational Behavior and Human Decision Processes, 2019, 151 : 90-103.)。对决策主体的能力预期的测量改编自Dietvorst 等人的相关研究(Dietvorst et al.,2015),被试需要回答一个由三个题项所构成的Likert 7 点量表,“政务服务中心的一般工作人员/政务AI 在处理日常的审批事项时,出现错误的可能性有多大”(1 为极不可能,7 为极有可能);“我对政务服务中心的相关工作人员的工作能力非常有信心”(1 为非常不赞同,7 为非常赞同);“我觉得,政务服务中心的相关工作人员在审批工作中的犯错的概率非常低”(1 为非常不赞同,7 为非常赞同)。在对第一个题项进行反向编码后,测得该量表的Cronbach's α 值为0.859②Cronbach's α 系数是最常用的信度测量方法。通常该系数的值在0 和1 之间。如果该系数不超过0.6,一般认为内部一致信度不足;达到0.7-0.8 时表示量表具有相当的信度,达0.8-0.9 时说明量表信度非常好。(参见Tavakol M, Dennick R. Making sense of Cronbach's alpha[J]. International journal of medical education, 2011, 2: 53.)。

(2)因变量2:感知能动性③感知能动性测量量表来自于Gray 等人对于机器人恐怖谷效应的研究,用于测量人类对机器人的拟人化特征的感知。(参见Kurt Gray, Daniel M. Wegner. Feeling robots and human zombies: Mind perception and the uncanny valley[J]. Cognition, 2012, 125(1) : 125-130.)。对感知能动性的量表改编自Gray 等人设计的心智知觉量表(Gray et al.,2012),并参照王忆希等人的研究(王忆希等,2021),结合实验背景做进一步的调整,最终测量题项为:“我觉得,政务服务中心的一般工作人员/政务AI 能够判断是非对错”“我觉得,政务服务中心的一般工作人员/政务AI 有属于自己的价值体系”“我觉得,政务服务中心的一般工作人员/政务AI能引导审批工作中的价值方向”。同样用Likert 7 点评分法(1 为非常不赞同,7 为非常赞同),该量表的Cronbach's α 值为0.775。

在完成上述测量后,我们按照Newton、马得勇等学者所提出的方法,测量了被试的一般性社会信任、互联网及IT 使用熟练度、家庭收入水平等控制变量(Newton,2011;马得勇,2019)。最后,被试汇报了自身的性别、年龄、受教育水平、党派身份、职业等人口统计学变量。

3.研究结果

(1)对决策主体感知的操控检验。参照前人研究,我们要求被试在阅读完试验材料后,通过回答一个单选题“在上述材料中,该政务服务中心目前主要由________负责服务办理与审批工作?A.政府工作人员;B.政务AI”来确认实验操纵的有效性。结果显示,全部被试都正确识别了操纵材料中所反映的决策主体。同时,独立样本T 检验(Independent T-Test)的结果显示,两组被试在性别(M 人工 = 0.4,MAI = 0.32,t = 0.83,p > 0.05)、年龄(M 人工 = 31.22,MAI = 31.98,t = 0.40,p > 0.05)、家庭收入水平(M 人工 = 5.52,MAI = 5.30,t =0.86,p > 0.05)、受教育水平(M 人工 = 3.06,MAI = 3.04,t = 0.16,p > 0.05)、职业(M 人工 = .18,MAI = .22,t = 0.50,p > 0.05)、党派身份(M 人工 = .22,MAI = .26,t = 0.46,p> 0.05)、互联网及IT使用熟练度(M人工 = 3.24,MAI = 3.48,t = 1.105,p > 0.05)、一般性社会信任(M 人工 = 5.58,MAI = 5.40,t = 0.83,p> 0.05)等各个控制变量上均不存在显著差异。因此,实验1 的操纵和随机分组是成功的。

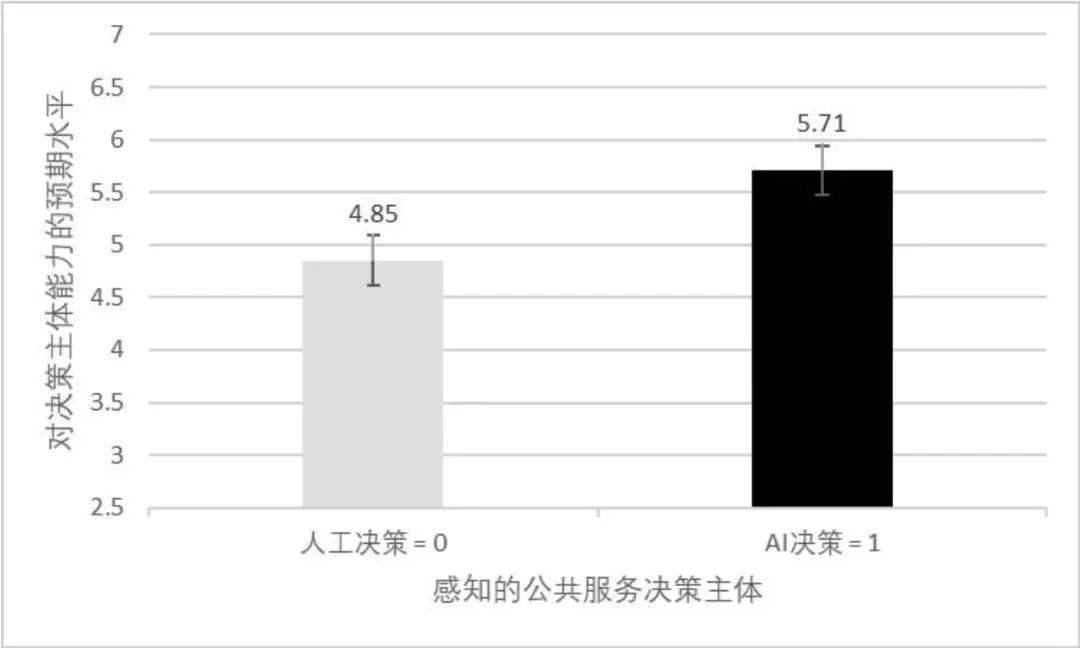

(2)假设检验。以二元变量“感知的公共服务决策主体”为自变量(“人工” = 0,“AI”= 1)、连续变量“对决策主体能力的预期水平”(取值范围为1 ~7)为因变量,构建的单因素协方差分析(ANCOVA)的结果显示:在控制了人口统计学变量、一般性社会信任和互联网及IT 使用熟练度等控制变量的情况下,自变量“感知的公共服务决策主体”对因变量“对决策主体能力的预期水平”存在显著且正向的影响(M 人工 = 4.85,MAI = 5.71,F(1,98)= 26.34,p < .001,partial η2=.218)(见下图2)。同时,未发现有控制变量对因变量产生了显著的影响。表明当得知公共服务中的决策主体是AI 时,人们会对其工作能力有着更高的期望。因此,H1 得到验证。

图2 决策主体对能力预期的影响

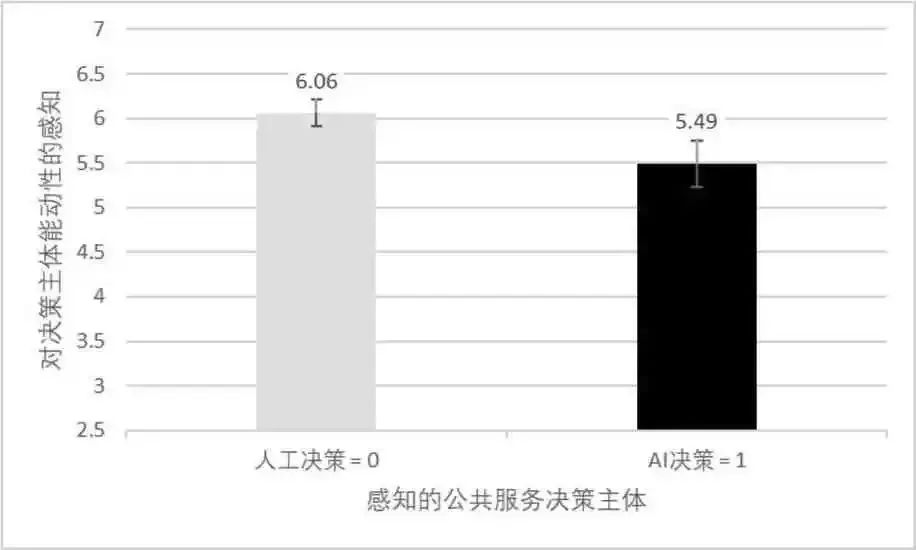

随后,以二元变量“感知的公共服务决策主体”为自变量(“人工” = 0,“AI” = 1)、连续变量“对决策主体能动性的感知”(取值范围为1 ~7)为因变量,构建的单因素协方差分析(ANCOVA)的结果显示:在控制了人口统计学变量、一般性社会信任和互联网及IT使用熟练度等控制变量的情况下,自变量“感知的公共服务决策主体”对因变量“对决策主体能动性的感知”,也被发现存在显著且正向的影响(M 人工 = 6.06,MAI = 5.48,F(1,98)= 9.75,p = .002,partial η2=.10),同时,未发现有控制变量对因变量产生了显著的影响。表明当获悉公共服务中的决策主体是AI 时,人们会对其能动性有着相较于一般人类工作人员更低的感知(见下图3)。因此,H3 得到验证。

图3 决策主体对感知能动性的影响

(3)结果讨论。实验1 通过两组组间实验设计验证了民众对于公共服务中决策主体的变化的认知。具体而言,我们发现,当获悉公共服务中的决策主体是人类时,民众有着较低的服务能力预期,但有着更高的主体感知能动性;而当由AI 取代人类担任公共服务的决策主体时,民众则会对其产生更高的服务能力预期,但表现出了相对较低的主体感知能动性。上述结果可以与现有研究相互印证(Dietvorst et al.,2015;Yam et al.,2021;Arikan et al.,2023)。考虑到人们倾向于对AI 的决策能力给予过高期望,那么在出现服务失败时是否会产生对这种预期的违背感?同时,在服务失败的情境下,人们倾向于要求归咎于具有能动性的决策主体、并要求其承担责任,那么对于只具有相对较低的能动性的AI,人们又会对其责任产生怎样的认知?实验2将在实验1的基础上,探讨上述问题。

(二)实验2

实验设计及实施步骤

实验2 的主要目的是检验在公共服务失败的情境下,公共服务中的决策主体对于民众认知的影响。实验问卷调研的起止时间为2022 年12 月4 日至5 日,采用两组组间实验设计。实验2 在与实验1 相同平台招募被试,但参与过实验1 的被试将会被排除在实验2 之外。实验2 共招募134 名被试,在剔除未通过注意力检测和答题时间过短(低于180 秒)和过长(长于600 秒)的被试后,共得到120 份有效问卷,有效率为89.6%。被试平均年龄为30.1 岁,其中男性57 人,占47.5%。

与实验1 一致,我们利用服务情景想象的方法,操纵被试所感知的在公共服务失败情景下的决策主体。我们以来自疫情防控部门的真实短信通知为模板,构建起基本的实验情景和两组实验刺激材料。在实验开始前,我们将全体被试以随机方式平均分配到两个分组中,2组被试将根据分组情况阅读下文中2 种刺激材料中的一种。实验程序如下:首先,被分入“人工服务失败组”的被试,将被告知收到了一条来自所在城市疫情防控部门的短信,通知其“根据社区网格员填报的相关资料,您可能与新冠病毒感染者存在直接或间接接触……根据《中华人民共和国传染病防治法》等法律规定和有关疫情防控要求,我办已将您的‘健康码’标记为‘黄码’……请在第一时间向所在您所在的社区(单位、宾馆)报告,……,并接受疫情防控相关管控措施。”而被分入“AI 服务失败组”的被试,则会看到一段与上一组几乎完全一致的简介,只是将“社区网格员填报的相关资料”替换为“大数据流调系统分析”。被试在阅读完上述材料后,将会要求填写一份对上述信息的感知测量量表。

随后,被分入“人工服务失败组”的被试,将被告知又在“十几分钟内”收到了一条来自与前一条短信相同渠道的信息,通知其“经核实,您被赋‘黄码’系社区网格员上报信息错误所导致,我们对由此给您带来困扰和不便深表歉意!我办已调整您的赋码状态,您的‘健康码’已转为‘绿码’”。同理,被分入“AI 服务失败组”的被试,则会被告知,其“被赋‘黄码’系大数据流调系统错误所导致”。

被试在阅读完实验材料后,在通过操纵检测后,填写关于感知能力预期违背(Perception of Expectation Violation)、 感 知 责 任 归 属(Perception of Responsibility Attribution)的量表。随后,被试被要求填写一份关于性别、年龄、职业、收入等人口统计信息和控制变量的简短问卷。

2.变量测量

实验2 主要关注以下两个因变量:被试在公共服务失败情境下的对能力预期违背的感知、以及对责任归属的感知。

(1)因变量3:能力预期违背的感知①“感知能力预期违背”是“能力预期”的相对概念,是对被评价主体“在未完成特定目标”时的评价(参见:Dietvorst B J, Simmons J P, Massey C. Algorithm aversion: people erroneously avoid algorithms after seeing them err[J]. Journal of Experimental Psychology: General, 2015, 144(1): 114.)。与实验1 一致,对公共服务失败中的决策主体能力预期违背的感知量表改编自Dietvorst 等人的相关研究(Dietvorst et al., 2015),被试需要回答一个由三个题项所构成的Likert 7 点量表,“社区网格员/大数据流调系统会在这件事情上犯错,出乎我的意料”(1 为非常不赞同,7 为非常赞同);“社区网格员/大数据流调系统会在这件事情上犯错,是不同寻常的”(1为非常不赞同,7 为非常赞同);“社区网格员/大数据流调系统会在这件事情上犯错,不符合人们对他的期待”(1 为非常不赞同,7 为非常赞同)。在对第一个题项进行反向编码后,测得该量表的Cronbach's α 值为0.749。

(2)因变量4:责任归属的感知①责任归属通常是指人们对于“谁应该为某一后果负责”的判断,通常基于蓄意性归因。(Ames D L, Fiske S T. Intentional harms are worse, even when they’re not[J]. Psychological science, 2013, 24(9):1755-1762.)。对责任归属的感知量表改编自Srinivasan 与Sarial-Abi(2021)设计的责任感知量表,并结合本实验背景做进一步的调整,最终测量题项为:“我觉得,上述错误应该归咎于社区网格员/大数据流调系统本身”“我觉得,社区网格员/大数据流调系统会因上述错误而承担责任”“我觉得,社区网格员/大数据流调系统会因上述错误而受到惩罚”。同样用Likert 7 点评分法(1 为非常不赞同,7 为非常赞同),该量表的Cronbach's α 值为0.839。

在完成上述测量后,我们按照与实验1 一致的方式,测量了被试的相关控制变量和人口统计学变量。

3.研究结果

(1)对公共服务失败感知的操控检验。与实验1 一致,我们要求被试在阅读完全部实验材料后,通过回答一个单选题“根据以上短信中所反映的信息,是下列选项中哪一个主体的错误,导致您收到了一条错误的疫情防控相关短信?A.社区网格员;B.大数据流调系统”来确认实验操纵的有效性。结果显示,全部被试都正确识别了操纵材料中所反映的决策主体。

此外,现有研究表明,在损失厌恶倾向的驱动下,所经历的服务失败的严重程度的感知和评价,也会影响人们对于服务失败的责任主体的评价和态度(Dietvorst et al.,2015)。因此,为确保实验操纵的对称性与有效应,实验2 在实验1 的操纵监测的基础上,增加了对被试的服务失败严重程度感知的测量。参照现有研究(Dietvorst et al.,2015),我们要求被试通过回答一个题项,来测量他们对第一阶段实验材料的认知态度:请问,对于你个人而言,你认为以上信息所反映内容的重要程度是?(“1 分”表示“非常不重要”,“7 分”表示“非常重要”)。

如前所述,在完成第一阶段材料阅读后,被试需要回答一个题项,来检测他们对第一阶段实验材料中所反映的事件的重视程度,以确保本实验所设计的公共服务失败对不同分组被试的影响程度的一致性。据此,独立样本T 检验(Independent T-Test)的结果显示,两组被试在感知公共服务失败的重要程度(M 人工失败 = 6.33,MAI 失败 = 6.12,t = 1.378,p > 0.05)、性别(M 人工失败 = .43,MAI 失败 = .52,t =.91,p > 0.05)、年龄(M 人工失败 = 29.83,MAI 失败 = 30.35,t = .38,p > 0.05)、家庭收入水平(M 人工失败 = 5.3,MAI 失败 = 5.38,t= .33,p > 0.05)、受教育水平(M人工失败 = 2.97,MAI 失败 = 2.95,t = .127,p > 0.05)、职业(M人工失败 = .17,MAI 失败 = .18,t = .238,p >0.05)、党派身份(M 人工失败 = .17,MAI 失败 = .17,t = .01,p > 0.05)、互联网及IT 使用熟练度(M 人工失败 = 5.25,MAI 失败 = 4.7,t= 1.657,p > 0.05)、一般性社会信任(M 人工失败 = 5.47,MAI 失败 = 5.48,t = .074,p > 0.05)等各个控制变量上均不存在显著差异。因此,实验2 的各项操纵和随机分组是成功的。

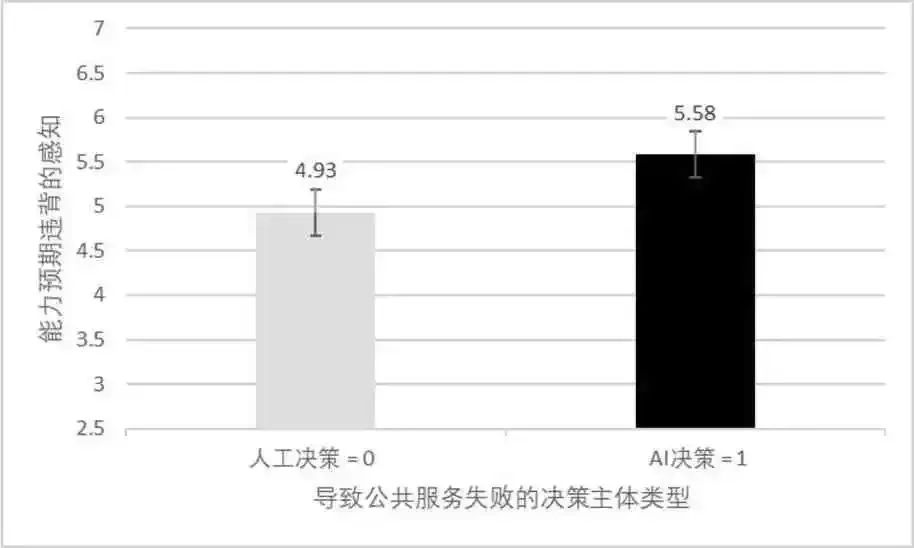

(2)假设检验。以二元变量“导致公共服务失败的决策主体类型”为自变量(“社区网格员” = 0,“大数据流调系统” = 1)、连续变量“能力预期违背的感知”(取值范围为1~7)为因变量,构建的单因素协方差分析(ANCOVA)的结果显示:在控制了人口统计学变量、一般性社会信任和互联网及IT 使用熟练度等控制变量的情况下,自变量“导致公共服务失败的决策主体类型”对因变量“能力预期违背的感知”存在显著且正向的影响(M 人工失败 = 4.93,MAI 失 败 = 5.58,F(1,119)= 15.378,p <.001,partial η2=.123)(见下图4)。同时,未发现有控制变量对因变量产生了显著的影响。由此表明,当获知导致服务失败的主体为AI 时,相比于人类工作人员,人们会感受到更高的能力预期违背感,因此H3 得到支持。

图4 导致公共决策失败的主体类型对感知能力预期违背的影响

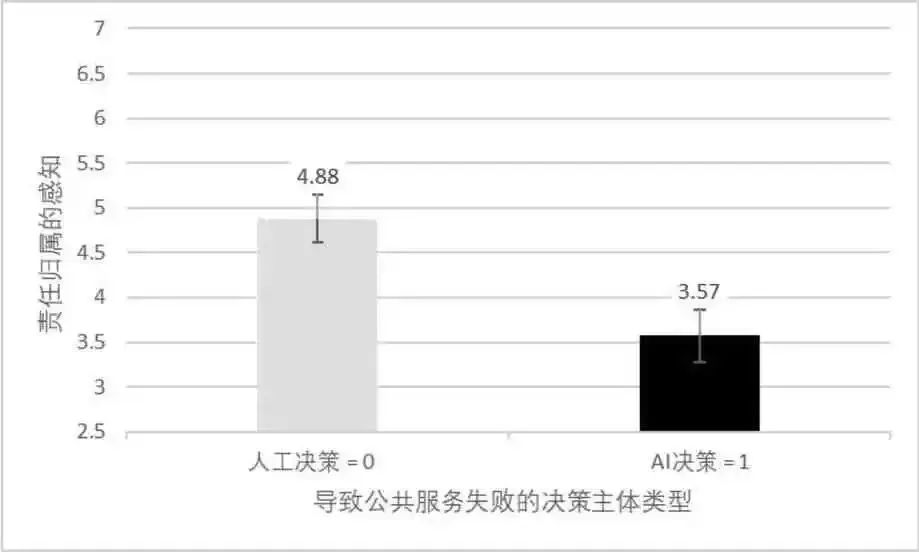

随后,以二元变量“导致公共服务失败的决策主体类型”为自变量(“社区网格员” = 0,“大数据流调系统” = 1)、连续变量“责任归属的感知”(取值范围为1 ~7)为因变量,构建的单因素协方差分析(ANCOVA)的结果显示:在控制了人口统计学变量、一般社会信任和互联网使用熟练度等控制变量的情况下,自变量“导致公共服务失败的决策主体类型”对因变量“对责任归属的感知”,也被发现存在显著且正向的影响(M 人工失败 = 4.88,MAI 失败= 3.57,F(1,119)= 40.172,p < .001,partial η2=.268)(见下图5)。同时,未发现有控制变量对因变量产生了显著的影响。由此表明,当获知导致服务失败的主体为AI 时,相比于人类工作人员,人们认为应该归属于AI 系统的责任较低,因此H4 得到支持。

图5 导致公共决策失败的主体类型对感知责任归属影响

(3)结果讨论。实验2 通过两组组间实验设计验证了民众在公共服务失败情境下,对于不同决策主体的态度和认知。具体而言,我们发现,当感知到造成公共服务失败的决策主体是AI 而非人类工作人员时,民众感觉到了更强的能力预期违背感,但同时,他们却更不倾向于将这种责任完全归咎于AI 本身。而当造成服务失败的决策主体是人类工作人员时,民众的感知模式则恰恰与此相反。换言之,在公共服务失败的情境下,人们往往希望归咎于具有更具能动性的决策主体,而不是有着更高的能力预期的决策主体。

四、结论与讨论

在人工智能迅速发展的时代,分析和识别AI 嵌入公共服务面临的风险与挑战,特别是随着公共决策与服务供应的治理主体从“单一人类”到多元化的“人类+AI”的转变下,民众对于AI 作为决策主体期望、感知与接受已成为当前学界集中关注的一个重要话题(姜李丹、薛澜,2022;徐辉、2020;梁军、孟克迪,2022;徐敏宁、罗鹏,2022;杨建武,2022;冉龙亚、陈涛、孙宁华,2021)。

有关民众对于“AI 在公共服务决策中的主体性地位”认识的形成是一个极其复杂的过程。目前,西方学界在AI 系统和算法的错误或错误决策和行动的情况下,如何处理责任归属和挑战等重要问题上还仍未达成共识(Boyd& Wilson,2017;Nagenborg et al.,2008;Johnson,2015)。学界通常基于公众对公共治理主体(如官员、公共机构、政治家等)的态度,特别是预期、问责(Accountability)、依从度和满意度(Satisfaction)等指标来评估公共服务的前景和绩效。然而,现有的相关研究往往从“AI+公共服务”的主体性迷思、行政伦理规范等基于“政府、治理者”的“形而上的”视角出发(徐辉,2020;梁军、孟克迪,2022)进行分析,辅以少量基于政策文本分析的定量研究(陈少威、吴剑霞,2022)。

相比之下,基于民众视角的、作为公共服务接受方的,对AI 嵌入公共服务的新感知、新挑战进行探讨的实证研究仍然较少(冉龙亚、陈涛、孙宁华,2022),而对AI 决策引起的“责任困境”的实证讨论则仍是空白。基于此,本文紧扣当前我国“AI+公共服务”的实践,基于公众主观评价模式,从对公共服务中的决策主体及其责任感知入手,实证检验了在未来新的治理模式下,民众对以AI 为代表的新兴公共服务决策主体的认识与感知。

本文研究发现的主要结论如下:第一,对中国当前的“AI+公共服务”实践而言,明确显示AI 在公共服务流程中的决策主体地位,会使民众对其工作能力产生过高的期望。第二,民众对于承担决策主体地位的AI 的能动性评价,低于承担相同地位的人类工作人员。第三,在发生公共服务失败、并且导致失败的决策主体为AI 时,民众会感受到更高水平的能力预期违背感知,但却只会将更少的责任归咎于AI。上述结论在一定程度上验证了一些学者所设想的,“当AI 参与的公共决策和公共服务导致了负面结果时,民众有可能难以判断相关决策责任归属,并因此难以通过申诉、复议或诉讼等方式提出异议、获得有效救济”的情景(Busuioc,2021;黄素珍,2020;李良成、李雨青,2021;杨建武,2022;赵洲洋,2022)。同时,由于在实验分析中未发现存在对因变量产生显著影响的控制变量,我们有理由相信,这种效果广泛可能存在于所收集样本的各个子群体中,因此具有较高的稳健性。

基于公共治理的逻辑,本文探索了在我国具体情境下,AI 作为决策主体在民众对公共服务的认知方面的潜在影响。基于心智感知理论与预期违背理论,文章从理论上丰富了对AI时代公共服务面临的风险与挑战的认识,特别是从单一到多元的治理主体转变下,民众对从“人—人”关系到“人—机”关系的全新认知。理论上,公众对公共治理主体的高期待有助于政府工作的开展,公众对政府认可时能提升政策执行效率、减少执行阻力。但是,正如前文所述的当前研究,以及实验1 的实证结果,在缺乏大量正确的相关知识的情况下,民众对于AI 的认知或许来源于媒体的塑造以及基于“机器式特征”的启发性认知模式。因此,对AI 过高的能力预期导致民众在服务失败中体会到了更高的能力预期背离感。此外,我们相信导致民众对于公共服务失败情境下的决策主体的不同认知模式的主要原因,即:在启发式思维模式下,能力预期与实际经验的背离所导致的预期违背,以及在心智感知模式下,对于AI 的低主体性评价(Bigman et al.,2019;Srinivasan &Sarial-Abi,2021;Yam et al.,2021)。上述认知模式也与经典的,“公众对公共决策主体的态度和评价,与其对公共政策的依从程度呈正相关”存在一定差异(Hetherington,1998)。希望本研究上述结论能够对进一步理解民众对公共服务的评价和认识过程有所启示。

相应的,本研究蕴含的政策启示主要体现在以下几个方面:首先,在我国从数字治理向智能治理转型的过程中,针对民众对公共服务中的AI 决策主体的过高能力期待与过低感知能动性,政府应当从公共服务与公共决策的领域、类型和流程出发,思考AI 主体在其中的“外显”与“内隐”问题。在对民众的宣传中,应避免过度强调AI 在公共服务的决策流程中对政府官员的能力优势与职位替代,使民众能够树立起对于AI 支持下的公共服务的正确认知。其次,各级政府可以通过微信公众号、微博、官方网页等多个渠道,加强对AI 支持下的公共服务创新的宣传。向民众强调传统的“政府—民众”互动所依靠的“人与人”之间的关系并没有完全被“人—机”关系所取代、以降低民众对公共服务失败情境下的“责任困境”的担忧。总之,应正确引导民众对我国“AI+公共服务”的客观认识,实现民众对治理主体和责任的正确期待,进而促进治理依从度和满意度的长远、有效提升。

当然,本文研究也存在一定的不足之处。首先,囿于数据来源和研究主题,本文在实验1 中对“AI+公共服务”的场景设计上,仅仅考虑了政府机构的外部环境、并没有明确该场景下的公共服务具体类型。因此,可以在未来的研究中重新进行实验设计并详加讨论。其次,由于数据类型所限,本文并没有采用目前社会科学领域前沿的因果中介模型,而是在一定程度上对于实验1 的场景进行模糊化处理,从而将实验1 得到的相关结论作为实验2 的预实验预前测,提供一种可能的解释机制,并在此意义上展开分析。总而言之,本文主要基于公众感知的逻辑,一定程度上揭示了相应的作用机制,研究方法和理论还有待完善,进一步深化民众形成对于“AI+公共服务”认知的因果机制解释。

文章来源:《社会政策研究》

作者:梁哲浩、陈涛